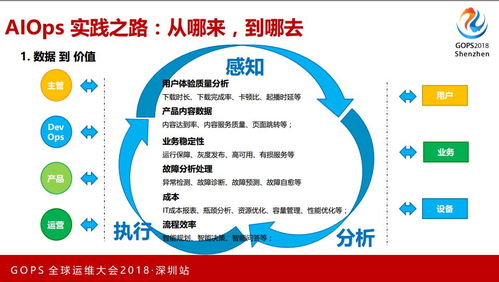

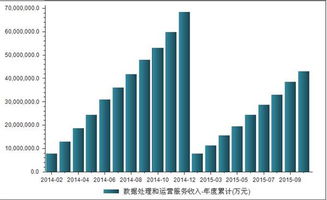

在數字化浪潮席卷全球的今天,大型互聯網企業與組織正面臨著前所未有的運維挑戰:服務于億級用戶,管理著百TB甚至PB級別的海量數據,傳統的運維模式已捉襟見肘。AIOps(智能運維)應運而生,成為破局的關鍵。本文將聚焦于AIOps技術棧中至關重要的一環——數據處理服務,探討其在應對超大規模場景下的增強實踐之路。

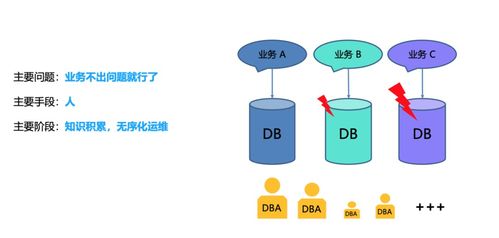

一、 基石:面對百TB數據的核心挑戰

構建服務于億級用戶場景的AIOps平臺,數據處理服務首先需要直面三大核心挑戰:

- 數據規模與吞吐:每日產生的運維日志、指標、追蹤數據輕松達到百TB級別,數據接入、實時處理與批量計算的吞吐量要求極高。

- 數據多樣性:數據來源異構,包括結構化指標、非結構化日志、半結構化的調用鏈數據,格式繁雜,統一處理難度大。

- 時效性與準確性:故障預警要求近實時(秒級/分鐘級)檢測,而根因分析、容量預測等場景又需要處理高維、復雜的歷史數據,對處理的延遲與結果的準確性有雙重嚴苛要求。

二、 增強:數據處理服務的架構演進

為應對上述挑戰,數據處理服務需從傳統的“管道”向智能、彈性、融合的“數據中樞”演進。

1. 分層彈性架構:

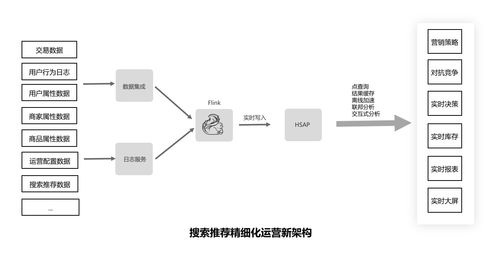

- 接入層增強:采用分布式、可水平擴展的接入網關(如基于Apache Flume, Kafka Connect的定制化Agent),支持多協議、多數據源,并具備邊緣預處理能力(如格式規整、臟數據過濾),減輕核心鏈路壓力。

- 實時處理層增強:核心是引入流批一體處理引擎(如Apache Flink)。它不僅能以極低延遲處理實時數據流進行異常檢測,還能無縫銜接歷史數據,進行時間窗口內的復雜事件處理(CEP)和狀態計算,為實時決策提供支持。

- 批量計算與存儲層增強:構建基于對象存儲(如S3/OSS)和分布式數據湖(如Hudi, Iceberg)的廉價存儲底座,配合Spark、Presto等計算引擎,處理海量歷史數據的挖掘、模型訓練與離線分析。實時與批處理的結果可統一寫入數據湖,形成閉環。

2. 智能數據治理:

- 自動化數據建模:利用元數據管理,自動識別數據源、推斷數據結構,并構建統一的運維數據模型(如將指標、日志、事件關聯到統一的“服務-實例”維度下),為上層分析提供一致視角。

- 數據質量監控:在數據處理流水線中嵌入數據質量檢查點,自動監測數據的完整性、及時性、一致性,并聯動告警,確保輸入AI模型的數據可靠。

- 生命周期智能管理:基于數據熱度、訪問模式及合規要求,制定策略自動執行數據的分層存儲(熱、溫、冷)、壓縮與歸檔,顯著降低成本。

3. 算法與處理的深度融合:

- 處理流程嵌入模型:將輕量級AI模型(如流式異常檢測算法、日志模式提取模型)直接嵌入數據管道。例如,在日志流經Kafka時即通過實時模型進行異常模式匹配和關鍵信息抽取,將結構化結果同步至下游,極大提升分析效率。

- 特征工程平臺化:構建特征計算平臺,將常用的運維特征(如時序指標的趨勢、周期性、方差)計算封裝為標準算子,供數據科學家和工程師在流批任務中直接調用,加速AI應用落地。

三、 實踐:關鍵場景的技術落地

- 海量日志實時解析與索引:結合流處理引擎與自然語言處理(NLP)模型,對非結構化日志進行實時聚類、模式學習和關鍵信息提取,生成結構化事件,并索引到高性能存儲(如Elasticsearch),使百TB日志的查詢與關聯分析從“不可能”變為“秒級響應”。

- 多維指標異常檢測:面對數十億維度的監控指標,利用流處理框架實時計算指標的統計特征,并集成多種輕量級無監督算法(如S-H-ESD, 移動平均)進行并行檢測。將實時流與歷史基線(存儲在數據湖中)快速對比,實現精準、可解釋的異常點定位。

- 大規模追蹤數據關聯分析:處理分布式調用鏈產生的海量Span數據,通過增強的流處理服務,實時構建完整的調用樹,計算服務依賴拓撲,并關聯對應的性能指標和錯誤日志,快速定位跨服務、跨數據中心的性能瓶頸與故障根源。

四、 未來展望

億級用戶百TB數據場景下的AIOps數據處理服務,其增強之路遠未停止。未來將向著更自動化(如基于強化學習的流水線自調優)、更云原生(深度整合K8s,實現計算資源的細粒度彈性調度)、更智能化(處理過程內置更多可解釋AI模型)的方向持續演進。數據處理服務不再僅僅是后臺支撐,而是驅動AIOps智能進化的核心引擎,為系統的穩定性、用戶體驗與業務增長提供堅實的數據動能。